预计 24 年电视全球零售额稳健增长,北美、西欧增速较快。据欧睿数据,预计 24 年电视全球零售额为 1180 亿美元,同比+0.6%,其中亚太/西欧...

2025-04-17 11 电子行业报告

AI 算力芯片主要包括 GPU、FPGA,以及以 VPU、TPU 为代表的 ASIC 芯片。 其中以 GPU 用量最大,据 IDC 数据,预计到 2025 年 GPU 仍将占据 AI 芯片 8 成 市场份额。然而,相较传统图形 GPU,通用型算力 GPU 在芯片架构上缩减了图形 图像显示、渲染等功能实现,具有更优的计算能效比,因而被广泛应用于人工智能 模型训练、推理领域。根据在网络中的位置,AI 芯片可以分为云端 AI 芯片 、边缘和终端 AI 芯片; 根据其在实践中的目标,可分为训练( training )芯片和推理( inference )芯 片。云端主要部署高算力的 AI 训练芯片和推理芯片,承担训练和推理任务,具体 有智能数据分析、模型训练任务和部分对传输带宽要求比高的推理任务;边缘和终 端主要部署推理芯片,承担推理任务,需要独立完成数据收集、环境感知、人机交 互及部分推理决策控制任务。由于英伟达 GPU 产品线丰富、产品性能顶尖、开发生态成熟,目前全球 AI 算 力芯片市场仍由英伟达垄断。根据中国信通院的数据,2021 年 Q4 英伟达占据了 全球 95.7%的 GPU 算力芯片市场份额,因此,英伟达数据中心业务营收增速可以 较好地反应全球 AI 芯片市场增速。

2023 财年,英伟达数据中心营收达到 150 亿 美元,同比增长 41%,FY2017-FY2023 复合增速达 63%,表明全球 AI 芯片市场 规模保持高速增长。英伟达的 GPGPU 是全球应用最为广泛的 AI 芯片,决定其性能的硬件参数主 要包括:微架构、制程、CUDA 核数、Tensor 核数、频率、显存容量、显存带宽 等。其中,微架构即 GPU 的硬件电路设计构造的方式,不同的微架构决定了 GPU 的不同性能,作为英伟达 GPU 的典型代表,V100、A100、H100 GPU 分别采用 Volta、Ampere、Hopper 架构;CUDA 核是 GPU 内部主要的计算单元;Tensor 核是进行张量核加速、卷积和递归神经网络加速的计算单元;显存容量和带宽是决 定 GPU 与存储器数据交互速度的重要指标。除 GPU 硬件之外,与之配套的软件开发体系亦是生态的重要组成部分。GPU 的生态包括底层硬件、指令集架构、编译器、API、基础库、顶层算法框架和模型 等,英伟达于 2006 年发布的 CUDA 平台是当今全球应用最为广泛的 AI 开发生态 系统。通用 GPU 与 CUDA 组成的软硬件底座构成了英伟达引领 AI 计算的根基, 当前全球主流深度学习框架均使用 CUDA 平台。

标签: 电子行业报告

相关文章

预计 24 年电视全球零售额稳健增长,北美、西欧增速较快。据欧睿数据,预计 24 年电视全球零售额为 1180 亿美元,同比+0.6%,其中亚太/西欧...

2025-04-17 11 电子行业报告

受下游需求影响及我国设备商国产替代加速,2024年我国引线键合机进口市场空间约6.18亿美元,仍显著低于 2021年高峰期进口市场空间的15.9亿美元...

2025-04-11 40 电子行业报告

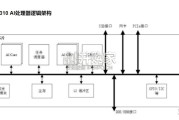

满足飞速发展的深度神经网络对芯片算力的需求,昇腾AI处理器本质上是一个SoC(System on Chip)。以昇腾310 AI 处理器为例,主要可以...

2025-03-29 75 电子行业报告

最新留言