预计 24 年电视全球零售额稳健增长,北美、西欧增速较快。据欧睿数据,预计 24 年电视全球零售额为 1180 亿美元,同比+0.6%,其中亚太/西欧...

2025-04-17 15 电子行业报告

在人工智能的浪潮中,端侧 大型语言模型(On-Device LLMs)迅猛发展且具备广 泛的应用前景。自2023年 起,随着参数量低于10B的 模型系列如Meta的LLaMA、 Microsoft的Phi系列等的涌 现,LLMs在边缘设备上运 行的可行性和重要性逐渐被 验证。这些模型不仅在性能 上取得了长足的进步,更通 过混合专家、量化和压缩等 技术,保持了参数量的优化, 为边缘设备的多样化应用场 景提供了强大支持。 进入 2024年,新模型的推出愈 发密集 , 如左图所示 , Nexa AI的Octopus系列、 Google的Gemma系列等, 不仅在文本处理上有所增强, 更在多模态能力上展现了新 的可能性,如结合文本与图 像等多模态输入,以适应更 复杂的用户交互需求。传统文本大型语言模型: 从Transformer架构发展而来,最初由编码器和解码器组成。如今,流行的模型如 GPT和LLaMA主要使用仅解码器架构。GPT模型在自注意力机制后应用层归一化,而LLaMA在每个子层前应 用归一化以提高训练稳定性。在注意力机制方面,GPT模型使用标准自注意力机制,允许模型在生成序列时 考虑输入序列中所有位置的信息,而LLaMA使用分组查询注意力(GQA),优化计算和内存效率。混合专家 (MoE)概念最早于1991年提出,在现代语言模型预训练中关键。MoE使用稀疏层减少计算资源,包含多 个独立的“专家”网络和一个门控网络,以确定token的路由。

标签: 电子行业报告

相关文章

预计 24 年电视全球零售额稳健增长,北美、西欧增速较快。据欧睿数据,预计 24 年电视全球零售额为 1180 亿美元,同比+0.6%,其中亚太/西欧...

2025-04-17 15 电子行业报告

受下游需求影响及我国设备商国产替代加速,2024年我国引线键合机进口市场空间约6.18亿美元,仍显著低于 2021年高峰期进口市场空间的15.9亿美元...

2025-04-11 42 电子行业报告

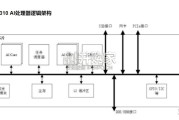

满足飞速发展的深度神经网络对芯片算力的需求,昇腾AI处理器本质上是一个SoC(System on Chip)。以昇腾310 AI 处理器为例,主要可以...

2025-03-29 75 电子行业报告

最新留言