预计 24 年电视全球零售额稳健增长,北美、西欧增速较快。据欧睿数据,预计 24 年电视全球零售额为 1180 亿美元,同比+0.6%,其中亚太/西欧...

2025-04-17 12 电子行业报告

HBM 主要用于 AI 和网通芯片。当代电子计算体系的表现完全依赖于处理器和内存的 相互配合,而来到了 AI 时代,大模型处理数据的吞吐量更是呈指数级增长,要想支撑如此 庞大的数据处理和传输,对内存就提出了更高的带宽需求。HBM 突破了内存容量与带宽瓶 颈,打破了“内存墙”对算力提升的桎梏,其具备高带宽、低功耗的特点,面对 AI 大模型千 亿、万亿的参数规模,服务器中负责计算的 GPU 几乎必须搭载 HBM。 高带宽是 HBM 的最大优势。HBM(High Bandwidth Memory,高带宽内存)是将多个 DDR 芯片堆叠后,和 GPU 封装在一起,实现大容量、高位宽的 DDR 组合阵列。通过增加 带宽、扩展内存容量,让更大的模型、更多的参数留在离核心计算更近的地方,从而减少内 存和存储解决方案带来的延迟。从技术角度看,HBM 使 DRAM 从传统 2D 转变为立体 3D, 充分利用空间、缩小面积,契合半导体行业小型化、集成化的发展趋势。目前全球 HBM 产能主要用于满足 Nvidia 和 AMD 的 AI 芯片需求。尽管内存制造商投 入大量资金扩产,但由于需求激增,HBM 的短缺状况继续恶化。占据全球 GPU 市场 80% 以上份额的 Nvidia 将于 2024 年第二季度开始量产 GH200 Grace Hopper Superchip,这是一 款采用 HBM3E 的新一代 AI 芯片。Nvidia 的 HBM 需求预计将从 2023 年大约 1200 万颗翻 倍增长到 2024 年 2400 万颗。 随着大型互联网客户自研 AI 芯片陆续推出,HBM 客户群预计将大幅扩容。除了 Nvidia 之外,HBM 的潜在客户数量也在快速增加,其中包括 Google、AWS 和 Meta 等正在积极自 研 AI 芯片的科技巨头。2023 年 8 月,谷歌推出了其内部 AI 张量处理单元(TPU)v5e,而亚 马逊正在通过 AWS 大力开发自己的芯片。

标签: 电子行业报告

相关文章

预计 24 年电视全球零售额稳健增长,北美、西欧增速较快。据欧睿数据,预计 24 年电视全球零售额为 1180 亿美元,同比+0.6%,其中亚太/西欧...

2025-04-17 12 电子行业报告

受下游需求影响及我国设备商国产替代加速,2024年我国引线键合机进口市场空间约6.18亿美元,仍显著低于 2021年高峰期进口市场空间的15.9亿美元...

2025-04-11 41 电子行业报告

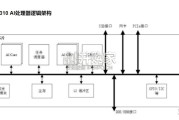

满足飞速发展的深度神经网络对芯片算力的需求,昇腾AI处理器本质上是一个SoC(System on Chip)。以昇腾310 AI 处理器为例,主要可以...

2025-03-29 75 电子行业报告

最新留言