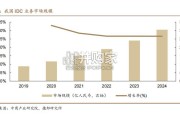

我国 IDC 行业起步较晚,正逐步向智算中心转型。受益于互联网+、数字经 济等国家政策的引导,以及云计算、大数据、物联网、人工智能等领域的蓬勃发 展,...

2025-04-03 67 云计算行业报告

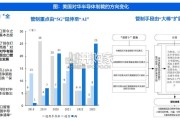

大模型推动算力需求增长。自2022年OpenAi发布的ChatGPT将大型语言生成模型和AI推向新高度以来,全球各大科技巨头纷纷拥 抱AIGC(AI-Generated Content,人工智能生成内容)。大模型通常包含数亿级的参数,需要消耗大量算力。据OpenAI团队发表 于2020年的论文《Language Models are Few-Shot Learners》,训练一次1746亿参数的GPT-3模型需要的算力约为3640 PFlop/s-day。AI大模型可以用于训练和推理,主要用在云端(数据中心侧)和边缘侧(终端侧)。 AI服务器作为算力的发动机,算力需求的增长将迎来AI服务器需求的快速增长。据IDC统计,2023年全球AI服务器市场规模预计为 211亿美元,2025年将达到达317.9亿美元,2023-2025年CAGR为22.7%。采购量方面,根据TrendForce的统计,截至2022年, 北美四大云端服务提供商Microsoft、Google、Meta、AWS在全球AI服务器采购中的总份额达到约66%, Microsoft和Google分 别占有全球19%以及17%的份额。服务器整机出货量放缓,AI服务器出货量稳步上升。2022年全球服务器出货量增长4.8%,达到约1360万台。然而,预计到2023年, 全年增长将放缓至1.5%。服务器整机出货量放缓的主要原因是大型云服务提供商的整体服务器购买量下降,集体转向高价AI服务器。 根据TrendForce数据,2023年AI服务器出货量逾达120万台,占据服务器总出货量的近9%,年增长达38.4%。预计2026年,AI服 务器出货量为237万台,占比达15%,复合年增长率预计保持25%。 AI服务器整机逻辑结构可确保各组件高效运行。如浪潮的NF5688M6型号AI服务器,其逻辑结构采用NVIDIA NVLink互联架构,可 基于硬件拓扑,实现 GPU:IB:NVMe=1:1:1的配比。此外,GPU之间交互效率高,可直接进行数据通信速率为400GB/s的P2P 交互。最后通过UPI 总线互联设计,该型号AI服务器可为深度学习业务场景提供高效计算性能。

标签: 云计算行业报告

相关文章

我国 IDC 行业起步较晚,正逐步向智算中心转型。受益于互联网+、数字经 济等国家政策的引导,以及云计算、大数据、物联网、人工智能等领域的蓬勃发 展,...

2025-04-03 67 云计算行业报告

预计 24-28 年全球 AIDC 装机 CAGR 达 73%,2030 年数据中心将使用全球发电量的 4.5%。 在全球数字化转型浪潮中...

2025-03-17 32 云计算行业报告

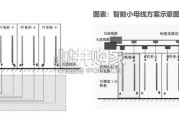

输配电系统是整个电力系统的重要组成部分,承担着将电能从发电厂输送到终端用电客户的职能。输配电系统分为输变电系统和配电系 统,其中输变电又分为输电和变电...

2025-03-14 63 云计算行业报告

2 0 1 8年至今,从特朗普政府到拜登政府,美对华半导体管制呈现出由“有限出口”向“全面出口管制”、由“ 5G”延伸至“AI ”、由 “大棒”扩展为...

2025-03-10 78 云计算行业报告

过高的温度会直接影响电子元件的性能,散热需求不可忽视。电子元器件使用 故障中,有半数以上是由于温度过高引起的。半导体元器件温度每升高 10℃,反 向漏...

2025-03-09 72 云计算行业报告

市场概览:2023年中国整体云服务市场规模为4758亿元,增速为19.2%。以大模型为代表的人工智能相关技术发展,驱动中国整 体云服务市场从“完善综合...

2025-02-04 48 云计算行业报告

最新留言