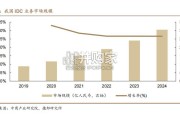

我国 IDC 行业起步较晚,正逐步向智算中心转型。受益于互联网+、数字经 济等国家政策的引导,以及云计算、大数据、物联网、人工智能等领域的蓬勃发 展,...

2025-04-03 67 云计算行业报告

全球AI大模型高速发展,算力需求高增驱动AI服务器三年CAGR约为29%的增长,带动算力芯片与光模块产业链受益。2023年以来,以ChatGPT、Sora为代表的多模态AI大模型横空出世,标志着人工智能技术已经进入一个新的纪元。未来,通用人工智能(AGI)有望集多模态感知、大数据分析、机器学习、自动化决策于一体,重塑人类工作和生产生活的方式,引领人类步入第四次工业革命。算力的高速增长需要更多的AI服务器支撑,2023年全球AI服务器约85.5万台,到2026年预计将达到236.9万台,CAGR为29.02%,从而驱动AI算力芯片与配套的光模块产业高增长。GPU是常见的AI芯片种类,AI芯片一般占据AI服务器成本70%左右,国产算力芯片在海外垄断格局下有望实现国产替代。AI芯片按照技术架构和应用需求可分为GPU、FPGA、ASIC和类脑芯片四大类,GPU是多功能的并行处理器,由于其通用程度高、软件生态丰富、制造工艺相对成熟,是目前最为普遍的AI芯片类型,占到中国AI运算市场的约89%。GPU是AI服务器的核心,约占近90%AI芯片市场份额,其价值量占AI服务器高达70-75%。2023Q4英伟达、AMD、英特尔分别占据全球GPU市场份额是80%、19%、1%。中国AI算力在文心一言、讯飞星火、通义千问等大模型支持下,长期需求规模较大。

HBM一定程度解决了算力增速大于存储增速的内存墙问题,由于其极高带宽、低功耗、小体积优势,成为GPU显存的最佳方案,随着AI算力芯片的高增长,HBM飞快发展,国内相关产业链企业或将受益。近几十年来,处理器的性能以每年大约55%速度快速提升,而内存性能的提升速度则只有每年10%左右。不均衡的发展速度造成了当前内存的存取速度严重滞后于处理器的计算速度,内存瓶颈导致高性能处理器难以发挥出应有的功效。HighBandwidthMemory,即高带宽内存,是一种新兴的DRAM解决方案。HBM具备极高带宽:达到1T/s;体积减小:比GDDR降低94%的尺寸;低功耗:高度集成后比GDDR拥有更小的电压与功耗。这些显著优势促使HBM快速发展,目前全球主要被韩美企业垄断,国内厂商纷纷布局,适合国产HBM发展的产品即将问世。光模块受益算力需求高增长,我国模块封装能力成熟,或将受益高速光模块需求增长,同时受益光芯片国产化进程。光模块用于服务器或者数据中心的高速互联,主要下游在电信与IDC,随着AI服务器发力发展,数通光模块在2026年或将占据60%份额。全球TOP10大光模块企业中,中国大陆占据5家,封装能力全球领先。从光模块成本结构看,光模块器件占据了光模块73%的成本,而光芯片与电芯片占据光器件的主要成本,高端光芯片(25G以上)国产替代率较低,国内企业在2.5G和10G光芯片领域基本实现了核心技术的掌握,国产化率分别为90%和60%,但是25G光芯片国产化率为20%,25G以上光芯片国产化率仅为5%,国产替代空间较大。

标签: 云计算行业报告

相关文章

我国 IDC 行业起步较晚,正逐步向智算中心转型。受益于互联网+、数字经 济等国家政策的引导,以及云计算、大数据、物联网、人工智能等领域的蓬勃发 展,...

2025-04-03 67 云计算行业报告

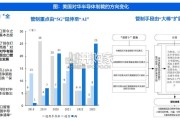

预计 24-28 年全球 AIDC 装机 CAGR 达 73%,2030 年数据中心将使用全球发电量的 4.5%。 在全球数字化转型浪潮中...

2025-03-17 32 云计算行业报告

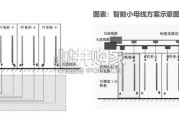

输配电系统是整个电力系统的重要组成部分,承担着将电能从发电厂输送到终端用电客户的职能。输配电系统分为输变电系统和配电系 统,其中输变电又分为输电和变电...

2025-03-14 63 云计算行业报告

2 0 1 8年至今,从特朗普政府到拜登政府,美对华半导体管制呈现出由“有限出口”向“全面出口管制”、由“ 5G”延伸至“AI ”、由 “大棒”扩展为...

2025-03-10 78 云计算行业报告

过高的温度会直接影响电子元件的性能,散热需求不可忽视。电子元器件使用 故障中,有半数以上是由于温度过高引起的。半导体元器件温度每升高 10℃,反 向漏...

2025-03-09 72 云计算行业报告

市场概览:2023年中国整体云服务市场规模为4758亿元,增速为19.2%。以大模型为代表的人工智能相关技术发展,驱动中国整 体云服务市场从“完善综合...

2025-02-04 49 云计算行业报告

最新留言