我国 IDC 行业起步较晚,正逐步向智算中心转型。受益于互联网+、数字经 济等国家政策的引导,以及云计算、大数据、物联网、人工智能等领域的蓬勃发 展,...

2025-04-03 67 云计算行业报告

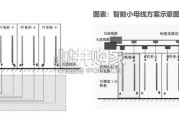

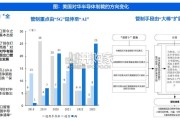

集群的有效算力可以分解为 GPU 利用率、集群的线性加速比,GPU 的利用率受制 于芯片架构的制程、内存和 I/O 访问瓶颈、卡间互联带宽和拓扑、芯片功耗等因素, “集群线性加速比”则取决于节点的通信能力、并行训练框架、资源调度等因素。因 而,如何设计高效的集群组网方案,满足低时延、大带宽、无阻塞的机间通信,从而 降低多机多卡间数据同步的通信耗时,提升 GPU 有效计算时间比(GPU 计算时间/ 整体训练时间)至关重要。基于中国移动研究院的《面向 AI 大模型的智算中心网络 演进白皮书》,AI 大模型对网络建设也提出了新的要求:超大规模组网:训练参数达到千亿-万亿级别的 AI 超大模型代表着超高速算力需 求,并进一步对应着大量的硬件需求及与之匹配的网络可延展能力。根据《面向 超万卡集群的新型智算技术白皮书》,当单集群中卡的数量达到万卡级别后,相 应的,如何实现最优运算效率、最佳数据处理能力、硬件层面的万卡互联、网络 系统的可用和易运维等,会成为 AI 智算中心的新议题。RDMA((Remote Direct Memory Access 远程直接内存访问)可以降低多机多卡间 端到端通信时延。在传统网络中,数据传输涉及多个步骤:首先将数据从源系统的内 核复制到网络堆栈,然后通过网络发送。最后,在接收端执行多个步骤后,将数据复 制到目标系统的内核中。RDMA 可以绕过操作系统内核,让一台主机可以直接访问 另外一台主机的内存。目前 RDMA 技术的主要采用方案有 Infiniband 和 RoCEv2(基 于 RDMA 的 Ethernet 技术,后简称为 RoCE)两种。

标签: 云计算行业报告

相关文章

我国 IDC 行业起步较晚,正逐步向智算中心转型。受益于互联网+、数字经 济等国家政策的引导,以及云计算、大数据、物联网、人工智能等领域的蓬勃发 展,...

2025-04-03 67 云计算行业报告

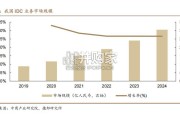

预计 24-28 年全球 AIDC 装机 CAGR 达 73%,2030 年数据中心将使用全球发电量的 4.5%。 在全球数字化转型浪潮中...

2025-03-17 32 云计算行业报告

输配电系统是整个电力系统的重要组成部分,承担着将电能从发电厂输送到终端用电客户的职能。输配电系统分为输变电系统和配电系 统,其中输变电又分为输电和变电...

2025-03-14 63 云计算行业报告

2 0 1 8年至今,从特朗普政府到拜登政府,美对华半导体管制呈现出由“有限出口”向“全面出口管制”、由“ 5G”延伸至“AI ”、由 “大棒”扩展为...

2025-03-10 78 云计算行业报告

过高的温度会直接影响电子元件的性能,散热需求不可忽视。电子元器件使用 故障中,有半数以上是由于温度过高引起的。半导体元器件温度每升高 10℃,反 向漏...

2025-03-09 72 云计算行业报告

市场概览:2023年中国整体云服务市场规模为4758亿元,增速为19.2%。以大模型为代表的人工智能相关技术发展,驱动中国整 体云服务市场从“完善综合...

2025-02-04 48 云计算行业报告

最新留言