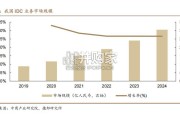

我国 IDC 行业起步较晚,正逐步向智算中心转型。受益于互联网+、数字经 济等国家政策的引导,以及云计算、大数据、物联网、人工智能等领域的蓬勃发 展,...

2025-04-03 67 云计算行业报告

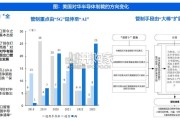

AI服务器按应用场景可分为训练和推理两种,2021年中国AI服务器推理负载占比约55.5%,未来有望持续提高; 训练对芯片算力要求更高,推理对算力的要求偏低;AI服务器采用异构形式,按芯片类型可分为CPU+GPU、CPU+FPGA、CPU+ASIC等组合; 目前GPU依然是实现数据中心加速的首选,其他非GPU芯片应用逐渐增多,IDC预计到2025年其他非GPU芯片占比超过20%; 一般来说,ASIC的性能最好,但是可编程性和灵活性较弱;在训练或者通用情况下,GPU则是更好的选择。服务器由电源、CPU、内存、硬盘、风扇、光驱等几部分构成,芯片成本(CPU、GPU等)占比较高,在25%-70%不等;

以AI服务器浪潮NF5688M6为例,京东售价约105万人民币,包括2颗Intel Ice Lake处理器(根据cnBeta,约5.3万元/颗) 和8颗NVIDIA A800 GPU(根据ZOL,约10.4万元/颗),CPU和GPU的价值量占比分别为10.10%和79.24%。参数量与算力需求呈正比,据ARK Invest预测,GPT-4参数量最高达15000亿个,则GPT-4算力需求最高可达31271 PFlop/s-day; 与此同时,国内外厂商加速布局大模型,其参数量均达到千亿级别,同步带动算力需求爆发式增长;据IDC预测,2023年AI服务器训练需求占比达41.5%,随着大模型的应用,该比例在2025年将降低至39.2%; 将GPT-4的推算结果作为训练需求,进一步推算2023/2025年推理需求最高达44081/48502 PFlop/s-day。

标签: 云计算行业报告

相关文章

我国 IDC 行业起步较晚,正逐步向智算中心转型。受益于互联网+、数字经 济等国家政策的引导,以及云计算、大数据、物联网、人工智能等领域的蓬勃发 展,...

2025-04-03 67 云计算行业报告

预计 24-28 年全球 AIDC 装机 CAGR 达 73%,2030 年数据中心将使用全球发电量的 4.5%。 在全球数字化转型浪潮中...

2025-03-17 33 云计算行业报告

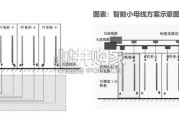

输配电系统是整个电力系统的重要组成部分,承担着将电能从发电厂输送到终端用电客户的职能。输配电系统分为输变电系统和配电系 统,其中输变电又分为输电和变电...

2025-03-14 63 云计算行业报告

2 0 1 8年至今,从特朗普政府到拜登政府,美对华半导体管制呈现出由“有限出口”向“全面出口管制”、由“ 5G”延伸至“AI ”、由 “大棒”扩展为...

2025-03-10 79 云计算行业报告

过高的温度会直接影响电子元件的性能,散热需求不可忽视。电子元器件使用 故障中,有半数以上是由于温度过高引起的。半导体元器件温度每升高 10℃,反 向漏...

2025-03-09 72 云计算行业报告

市场概览:2023年中国整体云服务市场规模为4758亿元,增速为19.2%。以大模型为代表的人工智能相关技术发展,驱动中国整 体云服务市场从“完善综合...

2025-02-04 49 云计算行业报告

最新留言